简介

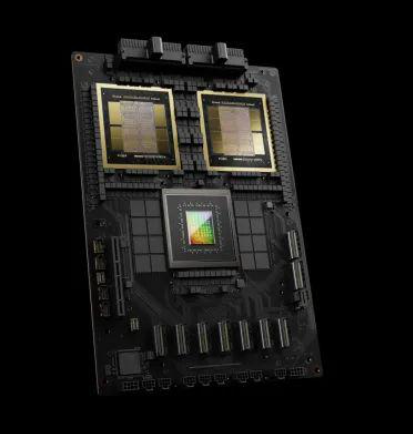

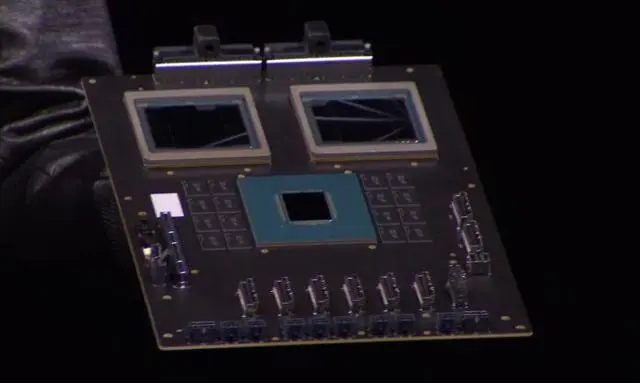

GB200基于Blackwell架构,由两个B200 Blackwell GPU和一个基于Arm的Grace CPU组成。Blackwell GPU采用台积电的4纳米工艺制程,将两块芯片整合到一起,使用10TB/sec NVLink 5.0连接,共有2080亿个晶体管,其AI性能为每秒20千万亿次浮点运算。GB200推理大语言模型性能比H100提升30倍,成本和能耗降至1/25。

发展历程

2024年3月19日,Blackwell GB200在英伟达召开的GTC开发者大会上正式发布,并计划于2024年内发货。

产品设计

GB200采用新一代AI图形处理器架构Blackwell。GB200包含两个B200 Blackwell GPU和一个基于Arm的Grace CPU组成。

产品性能

GB200推理大语言模型性能比基于Hopper架构的H100加速卡提升30倍,成本和能耗降至25分之一。Blackwell架框的AI性能可达20 petaflops,而H100仅为4 petaflops。

同时,GB200在参数为1,750亿的GPT-3 LLM基准测试中,性能是H100的7倍,训练速度是H100的4倍。

核心架构

Blackwell

Blackwell以美国国家科学院首位黑人学者David Blackwell的名字命名。Blackwell架构GPU由2080亿个晶体管组成,采用量身定制的台积电4纳米工艺制造,整合两个独立制造的裸晶(Die),共有2080亿个晶体管,然后通过NVLink 5.0像拉链一样捆绑芯片。

Blackwell Die的浮点运算能力要比Hopper Die高出25%,并且每个封装中有两个Blackwell芯片,总性能提高2.5倍。如果处理FP4八精度浮点运算,性能还能提高到5倍。但取决于各种Blackwell设备的内存容量和带宽配置。

第二代Transformer引擎

结合了Blackwell Tensor Core技术和TensorRT-LLM和NeMo Megatron框架中的英伟达先进动态范围管理算法,Blackwell将通过新的4位浮点AI支持双倍的计算和模型大小推理能力。

第五代NVLink

为提高数万亿参数和混合专家AI模型的性能,新一代英伟达NVLink为每个GPU提供了突破性的1.8TB/s双向吞吐量,确保最复杂LLM之间多达576个GPU之间的无缝高速通信。

RAS引擎

Blackwell支持的GPU包含一个专用引擎,实现可靠性、可用性和服务性。此外,Blackwell架构还增加了芯片级功能,利用基于AI的预防性维护进行诊断和预测可靠性问题。

安全人工智能

先进的机密计算功能可在不影响性能的情况下保护AI模型和客户数据,并支持新的本机接口加密协议。

解压缩引擎

专用解压缩引擎支持最新格式,加快数据库查询,提供数据分析和数据科学的最高性能。

产品参数

名称 | 内容 |

架框 | Blackwell |

GPU | 2个B200 Blackwell GPU |

CPU | 1个Grace CPU |

AI算力 | 20千万亿次浮点运算/s |

合作企业

企业名称 | 亚马逊、谷歌、微软、甲骨文 |

注:以上截至2024年3月19日 |

相关评价

人工智能发展的力量是推动经济变革的驱动力,基于Blackwell架构的芯片是“推动这场工业革命的引擎”。(英伟达创始人兼CEO黄仁勋 评)